آموزش رفع خطاهای سایت توسط Google Webmaster Tools و افزایش seo

آشنایی با Crawl Errors در ابزار وبمستر گوگل

برای تصحیح خطا شناسایی شده توسط ربات خزنده گوگل در سایت خود باید با بخش مختلف ابزار Crawl Errors که به تازگی دست خوش تغییراتی شده است آشنا شویم تا با مشاهده خطا در دسته بندی موجود در این ابزار بهترین راه کار رفع آن را تشخیص دهیم و از این طریق سایت خود را برای موتور جستجوگر گوگل بهینه سازی و سئو کنیم. برای دسترسی به این بخش پس از مراجعه به Google Webmaster Tools و انتخاب سایت خود از لیست سایتهایی که به این سرویس اضافه کردهایم از کافی است از منوی سمت چپ تصویر گزینه Health و سپس Crawl Errors را انتخاب کنیم.

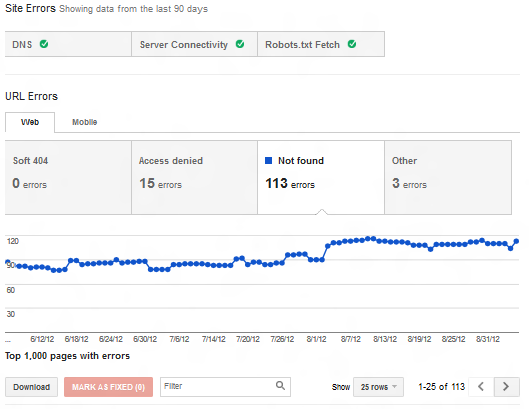

در تصویر بالا نیز مشاهده میکنید این قسمت از ابزار وبمستر گوگل به دو بخش Site Errors و URL Errors تقسیم شده است که هر یک از آنها نیز زبانه های متفاوتی را در خود دارند. در چند هفته گذشته گوگل رویداد این بخش را به ایمیل وبمسترهای عضو Google Webmaster Tools ارسال میکند که متن آن چیزی شبیه به زیر است.

|

۱

۲

۳

۴

۵

۶

۷

۸

۹

۱۰

۱۱

۱۲

۱۳

۱۴

۱۵

۱۶

۱۷

۱۸

۱۹

۲۰

۲۱

۲۲

۲۳

۲۴

۲۵

۲۶

۲۷

۲۸

|

Over the last 24 hours, Googlebot encountered 13 errorswhile attempting to access your robots.txt. To ensure thatwe didn’t crawl any pages listed in that file, we postponedour crawl. Your site’s overall robots.txt error rate is 100.0%.You can see more details about these errors in Webmaster Tools.Recommended actionIf the site error rate is 100%:Using a web browser, attempt to accessIf you are able to access it from your browser, then your sitemay be configured to deny access to googlebot. Check theconfiguration of your firewall and site to ensure that you are notdenying access to googlebot.If your robots.txt is a static page,verify that your web service has proper permissions to access thefile.If your robots.txt is dynamically generated, verify that thescripts that generate the robots.txt are properly configured andhave permission to run. Check the logs for your website to see ifyour scripts are failing, and if so attempt to diagnose the causeof the failure.If the site error rate is less than 100%:Using Webmaster Tools, find a day with a high error rate andexamine the logs for your web server for that day. Look for errorsaccessing robots.txt in the logs for that day and fix the causesof those errors. The most likely explanation is that your site isoverloaded. Contact your hosting provider and discuss reconfiguringyour web server or adding more resources to your website.After you think you’ve fixed the problem, use Fetch as Google tofetch robots.txt to verify that Googlebot can properly access yoursite... |

همانطور که مشاهده میکنید دلیل خطا (در این نمونه فایل Robots.txt) و درصد تعداد دفعات روبرو شدن با آن نسبت به کل مرور انجام شده در این نامه درج شده است و راهنماییهای خوبی هم برای رفع مشکل ارائه شده است. اما در هر صورت اگر نمیدانید مشکل از کجا است و چگونه آن را حل کنید بهتر است به ادامه این آموزش دقت کنید.

» برای دیدن آموزش کامل اینجا کلیک کنید

» منبع : freescript.ir

- آخرین بروزرسانی مطلب : ۱۹ مرداد ۱۳۹۸

- منبع مطلب : فری اسکریپت

مطالب پیشنهادی

- آموزش امنیت وردپرس

- آموزش نصب افزونه وردپرس

- کارهایی که باید بعد از نصب وردپرس انجام داد

- نمایش نوشته های هفته گذشته در وردپرس

- مدیریت پایگاه داده وردپرس با PhpMyAdmin

- آموزش برون ریزی و درون ریزی کاربران در وردپرس

- انتخاب دامنه مناسب برای سایت

- روش ها و ترفند های افزایش بازدید سایت

- محاسبه نرخ پست فروشگاه ساز ووکامرس

- نمایش تعداد اعضاء شبکه اجتماعی در وردپرس

- صفحه بندی کوئری وردپرس

- چگونه هشدار دیدگاه جدید را در وردپرس غیر فعال کنیم؟

عالی بوووووود

ممنون

ممنون از مطلب خوبتون